A relação entre Nvidia e o mercado de data centers da China ganhou mais um episódio inesperado. Depois de meses repetindo a investidores que praticamente havia zerado o negócio no país por causa dos controles de exportação dos Estados Unidos, a empresa agora recebeu autorização para voltar a vender as GPUs Hopper H200 para clientes chineses. No papel, parece um retorno triunfal.

Mas, olhando de perto, é um retorno cheio de asteriscos: tarifa de 25 por cento em cada chip, regras políticas mais duras e um ecossistema local que evoluiu rápido demais para simplesmente abrir os braços de novo para o hardware americano.

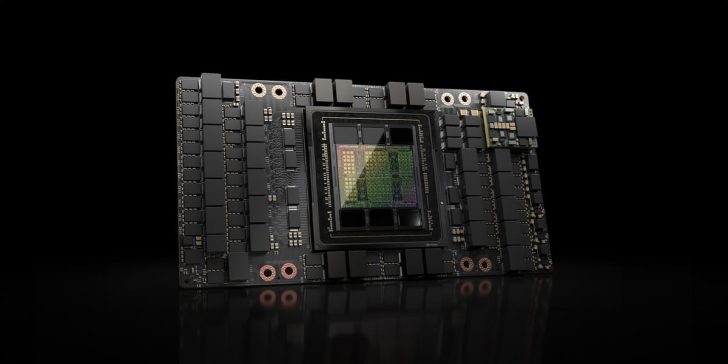

Por muito tempo, a China foi um dos mercados mais importantes da Nvidia fora dos EUA. A geração A100 e, depois, a H100 virou padrão em data centers de gigantes como Baidu, Alibaba e Tencent, alimentando sistemas de recomendação, nuvens públicas e as primeiras gerações de modelos de linguagem de grande porte. Esse ciclo foi quebrado quando Washington começou a apertar o cerco: primeiro proibiu o envio de A100 e H100 completos, depois forçou a criação de versões especiais com desempenho capado, como A800, H800 e H20, desenhadas especificamente para ficar logo abaixo dos limites técnicos definidos pelo regulador. Quando as regras foram endurecidas de novo, até esses produtos intermediários deixaram de ser permitidos. Não à toa, Jensen Huang passou a dizer em público que a receita de data center vinda da China tinha sido praticamente anulada.

A nova decisão que libera a venda da Hopper H200 em território chinês não reverte todo esse processo, mas cria uma exceção bastante peculiar. O principal condicionante é financeiro: a cada GPU H200 exportada para a China, a Nvidia precisa repassar 25 por cento do valor em forma de uma espécie de sobretaxa. Na prática, é um tributo adicional em cima de um produto que já nasce caro. A conta da empresa fica simples e desagradável: ou aceita margens menores para manter o preço mais ou menos no mesmo patamar, ou repassa essa cobrança para o cliente final, encarecendo ainda mais as máquinas. Em qualquer dos cenários, o H200 chega à China com menos apelo econômico do que teria em tempos de mercado livre.

Enquanto isso, Pequim vem redesenhando silenciosamente o mapa de compras de hardware para o próprio setor público e para companhias fortemente ligadas ao Estado. Orientações recentes para órgãos governamentais, estatais e provedores de nuvem que dependem de contratos oficiais apontam cada vez mais para a adoção de chips nacionais em clusters de inteligência artificial, especialmente em cargas de inferência. Em licitações e documentos de compras, relatos de mercado falam em cláusulas que desclassificam automaticamente propostas baseadas em GPUs de Nvidia, AMD ou Intel. Sob essa lógica, o sinal verde vindo de Washington para o H200 aparece tarde demais: boa parte dos grandes projetos já foi direcionada para fornecedores locais, e o espaço para o retorno de placas americanas fica confinado a nichos bem mais estreitos.

Esse reposicionamento político foi possível porque a China não ficou parada esperando a boa vontade do regulador americano. Empresas como a Huawei avançaram agressivamente com a linha Ascend 910B e 910C, enquanto designers como a Cambricon disputam seu lugar em data centers domésticos. Em materiais de marketing e benchmarks selecionados, esses chips já são comparados diretamente à família Hopper, com promessas de desempenho equivalente ou superior em determinados tipos de workload. Paralelamente, o país tenta construir algo maior: um stack tecnológico mais soberano, que vá do sistema operacional à nuvem, passando por frameworks de machine learning, bibliotecas e ferramentas próprias. Não é apenas sobre treinar chatbots; é sobre reduzir ao máximo a dependência de tecnologia crítica importada em áreas como finanças, telecom, segurança e indústria.

Mesmo assim, a Nvidia ainda guarda uma vantagem que pesa muito: o software. Décadas de investimento em CUDA, cuDNN e todo o conjunto de bibliotecas, compilers e ferramentas transformaram o ecossistema da empresa em um padrão de fato para pesquisa e desenvolvimento em IA. Relatos de equipes chinesas que migraram modelos grandes para aceleradores locais são parecidos: falta de maturidade nas ferramentas, stacks de software cheios de lacunas, drivers instáveis, ausência de equivalentes para muitas bibliotecas otimizadas para CUDA. Várias equipes descobrem, na prática, que o custo de reescrever kernels, ajustar pipelines e caçar bugs é alto, tanto em tempo quanto em dinheiro. Não é à toa que alguns preferem contratar computação em nuvens fora do país, em vez de redesenhar tudo do zero para um ambiente ainda imaturo.

É nesse contexto que o H200 pode encontrar uma brecha. Empresas que não estão totalmente presas às exigências de compras estatais e que dependem heavy de código escrito para CUDA podem achar mais racional pagar mais caro por GPU americana do que pagar com meses de atraso e retrabalho para adaptar toda a pilha a um chip local. A equação fica ainda mais sensível para quem está em corrida apertada com concorrentes globais e não pode se dar ao luxo de congelar o roadmap por causa de migrações técnicas dolorosas.

Por outro lado, o componente político dessa história é inescapável. Quando surgiram os primeiros rumores sobre uma possível versão de H200 ajustada para o mercado chinês, o próprio Jensen Huang chegou a dizer que a China não aceitaria um produto que não entregasse o desempenho que seus clientes exigem. Agora o cenário parece quase invertido: os Estados Unidos topam liberar a geração Hopper, desde que venha acompanhada de um tributo pesado, enquanto Pequim responde com regras de compra que, na prática, empurram os maiores contratos para chips domésticos. Entre investidores e analistas, essa combinação vem sendo lida como uma espécie de imposto disfarçado de política industrial: em vez de rever a estrutura tributária corporativa como um todo, cria-se uma cobrança específica em cima de um tipo de hardware que virou peça central na disputa geopolítica do momento.

Importante também notar o que continua vetado. A autorização atual não alcança as próximas gerações da Nvidia. Arquiteturas como Blackwell e Rubin, anunciadas como novos saltos de desempenho, memória e eficiência energética, seguem fora do alcance do mercado chinês. A AMD, segundo reportagens de bastidores, conseguiu janelas parecidas para alguns de seus aceleradores, mas sob limitações de performance e tipo de cliente bastante rigorosas. Em outras palavras, a mensagem de Washington é clara: a China pode, em condições controladas, comprar variações de chips de ontem, mas não terá acesso às tecnologias mais avançadas de amanhã. Nos mercados financeiros, esse detalhe é crucial. As ações da Nvidia costumam reagir com fortes altas a manchetes sobre relaxamento de exportações, para depois devolver parte dos ganhos à medida que os investidores percebem o quão estreito é o corredor aberto pelas exceções.

No fim das contas, o caso H200 diz muito mais sobre o novo equilíbrio entre Estado e big techs do que sobre uma única placa de vídeo. Críticos apontam que a guerra dos chips de IA escancarou o quanto governos e grandes grupos privados estão entrelaçados em ambos os lados do Pacífico. A taxa de 25 por cento é lida por alguns como tentativa improvisada de recuperar parte da receita perdida com décadas de alívio em impostos corporativos, só que de forma opaca e concentrada em um setor específico. Outros alertam que transformar licenças de exportação em arma de política externa só acelera a decisão de países emergentes de montar seus próprios ecossistemas de semicondutores, fragmentando um mercado que, até pouco tempo atrás, era relativamente integrado.

Para a Nvidia, o retorno do H200 à China está longe de ser um reset completo. O caminho de volta é estreito, caro e politicamente frágil. Mesmo que as remessas cresçam, dificilmente vão recriar o boom de data centers chineses comprando GPUs aos montes no auge da era pré-sanções. A concorrência doméstica melhora a cada trimestre, as barreiras regulatórias tendem a subir, e as plataformas realmente de ponta, baseadas em Blackwell e Rubin, permanecerão, pelo menos por enquanto, restritas a outros mercados. Ao mesmo tempo, as dificuldades de software dos chips locais e a dependência histórica de CUDA garantem que ainda exista demanda pelo hardware da Nvidia. O resultado é um equilíbrio incômodo: a aprovação do H200 não é irrelevante, mas está longe de ser uma vitória decisiva. É apenas mais um lance em uma disputa longa, cara e profundamente política pela infraestrutura que vai sustentar a próxima década de inteligência artificial.