Roteiro da AMD Instinct MI400 e MI500: desafio real ao domínio de IA da NVIDIA

Em poucos anos, as GPUs para inteligência artificial deixaram de ser um nicho de data center para virar o tipo de chip mais disputado do planeta. Hoje, a NVIDIA reina praticamente sozinha com plataformas como Hopper, Blackwell e a futura Vera Rubin, abastecendo desde big techs até governos. Mas a AMD não quer mais ficar na arquibancada. No Financial Analyst Day 2025, a empresa mostrou uma estratégia bem mais agressiva com as linhas Instinct MI400, prevista para 2026, e MI500, planejada para 2027, deixando claro que pretende disputar cada rack de IA nos grandes data centers.

Em vez de lançamentos espaçados e imprevisíveis, a AMD está assumindo um ritmo anual para suas GPUs de data center, copiando o que a própria NVIDIA faz há anos. As gerações atuais baseadas em CDNA 3 e CDNA 4 – como MI300X, MI325X e MI350X – já colocaram a AMD no radar de quem treina modelos de linguagem gigantes ou roda HPC pesado. Agora, MI400 (CDNA 5) e, logo na sequência, MI500 (em uma arquitetura CDNA Next/UDNA) são apresentados como os próximos degraus: cada passo prometendo mais desempenho bruto, mais memória e mais largura de banda para alimentar a fome quase infinita da IA generativa.

Instinct MI400: CDNA 5, HBM4 e foco em racks de IA

A família Instinct MI400 é a estrela da AMD para 2026. Baseada na arquitetura CDNA 5, ela está longe de ser um simples refresh da MI350. A empresa fala em dobrar a capacidade de cálculo: cerca de 40 petaFLOPs em FP4 e 20 petaFLOPs em FP8 por GPU, mirando tanto inferência ultra densa quanto treinamentos de modelos enormes. Na prática, isso significa conseguir rodar redes cada vez mais pesadas usando quantizações mais agressivas, mas ainda preservando a precisão, o que ajuda provedores de nuvem a extrair mais tokens, imagens e vídeos por watt e por unidade de rack.

Só que números de FLOPs, sozinhos, não treinam modelos gigantes. O grande salto do MI400 está na memória. A AMD migra para HBM4, aumentando o volume de 288 GB de HBM3e do MI350 para impressionantes 432 GB por acelerador – um ganho de 50% em capacidade. Ao mesmo tempo, a largura de banda anunciada vai para até 19,6 TB/s, mais que o dobro da geração anterior. Para quem trabalha com modelos que flertam com trilhões de parâmetros em grandes implantações, isso é ouro: mais parâmetros cabendo em um único GPU significam menos fragmentação da rede e menos gargalo em comunicação entre nós.

O MI400 também foi pensado para escalar além do pacote. A AMD fala em algo em torno de 300 GB/s de largura de banda de interconexão por GPU para ligações entre múltiplos aceleradores. E, em vez de amarrar tudo a uma malha totalmente proprietária, a empresa dá destaque a redes em escala de rack baseadas em padrões abertos, como UALoE, UAL e UEC. Em bom português: a proposta é se encaixar melhor na infraestrutura que os data centers já possuem, sem exigir que o cliente reconstrua o prédio inteiro em torno de um único fornecedor.

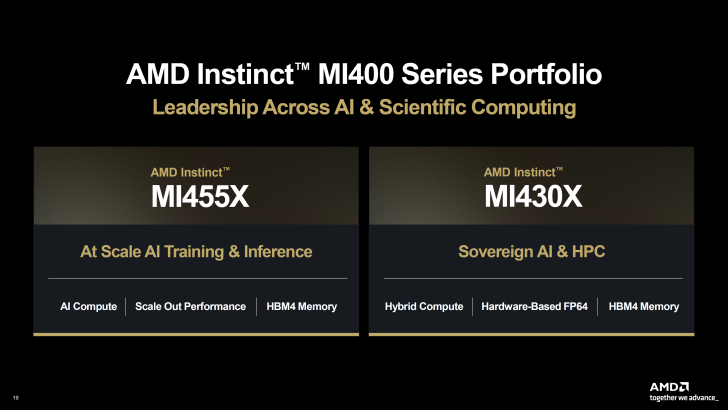

MI455X e MI430X: dois sabores da mesma geração

Dentro da família MI400, a AMD já desenhou dois produtos bem definidos. O Instinct MI455X é o topo de linha voltado para treinamento de IA em larga escala e inferência de altíssima densidade. É esse chip que hiperescaladores vão olhar quando precisarem montar racks lotados de grandes modelos de linguagem, mas ainda com folga de memória para futuras versões mais pesadas. Com 432 GB de HBM4, CDNA 5 completa e interconexões de alta velocidade, o MI455X quer obrigar qualquer projeto novo de cluster a considerar seriamente a opção vermelha, e não apenas assumir que “vai ser NVIDIA de novo”.

Já o Instinct MI430X mira um público um pouco diferente. Ele mantém o mesmo patamar de memória HBM4, mas reforça o desempenho em FP64 e a integração CPU + GPU, mirando HPC clássico e o chamado “IA soberana” – cenários em que governos, universidades e grandes empresas querem capacidade de IA de alto nível sob sua própria jurisdição, tanto legal quanto física. A mensagem é clara: o MI430X é peça de construção de supercomputadores em que convivem simulações científicas pesadas, modelos de clima, IA de uso nacional e workloads sensíveis no mesmo hardware, normalmente acompanhado de CPUs EPYC.

AMD versus NVIDIA Vera Rubin: mais do que FLOPs

Nos materiais oficiais, a AMD mostra bastante confiança na comparação direta com a plataforma Vera Rubin da NVIDIA. A empresa fala em 1,5x mais capacidade de memória, mesma faixa de largura de banda, paridade em FLOPs em FP4/FP8, escala interna comparável dentro do nó e cerca de 1,5x de vantagem em escala externa, entre GPUs. Se essas promessas se confirmarem no silício real, caem algumas das desculpas mais usadas para ficar 100% no ecossistema verde.

Mas quem já construiu cluster grande sabe que não é a tabela de especificações que treina modelo – são sistemas completos. E aí entra o ponto que muita gente comenta: não basta ter o “GPU mais rápido”, é preciso conseguir montar verdadeiras fábricas de IA com milhares de aceleradores trabalhando em conjunto. A NVIDIA já provou que sabe fazer isso, vendendo não só chips, mas plataformas completas, com rede, software e suporte. A AMD, com o MI400, tenta mostrar que consegue chegar nesse patamar com ROCm amadurecendo, HBM4 generoso e interconexões mais abertas, diminuindo o risco de lock-in total em um único fornecedor.

MI500 em 2027: o salto seguinte

Se o MI400 é o movimento para entrar de vez no jogo nos próximos anos, o Instinct MI500 é a aposta mais ousada da AMD para 2027. A empresa ainda guarda muitos detalhes, mas já fala em uma arquitetura CDNA Next ou UDNA, novo nó de fabricação e ganhos relevantes em densidade de cálculo, memória e interconexão. A ideia não é apenas substituir o MI400 em sistemas existentes, mas ser a base de racks de IA realmente novos, pensados desde o começo para essa geração.

Naturalmente, a comunidade já especula: será que veremos algo como um MI450X intermediário, talvez até em um nó mais avançado que os supostos 3 nm da Vera Rubin? Difícil saber agora, mas o fato de esse tipo de conversa existir mostra como o cenário mudou. Há poucos anos, a pergunta era se a AMD conseguiria ao menos se aproximar da NVIDIA em alto desempenho. Hoje, já se discute em quais métricas ela pode, eventualmente, liderar.

E os gamers no meio da febre de IA?

Enquanto investidores vibram com cada novo acelerador, uma outra turma acompanha tudo isso com certo ranço: os jogadores de PC. Muitos olham para as apresentações da AMD e veem a CEO Lisa Su falando quase só de IA, data center, Instinct e EPYC, e praticamente nada de Radeon gamer. A sensação é de que os melhores nós de fabricação, orçamentos e prioridades vão todos para MI400 e MI500, enquanto a linha de placas de vídeo para jogos anda em ritmo mais lento.

A realidade é mais complicada. Sim, os aceleradores de IA hoje são onde está a maior margem, e é natural que AMD e NVIDIA priorizem esse segmento. Mas a tecnologia desenvolvida para Instinct não fica trancada no data center para sempre. Empacotamento com HBM, novas topologias de cache, truques de energia e interconexões avançadas acabam, com o tempo, migrando para GPUs de games e de estação de trabalho. A própria AMD já apontou que suas futuras arquiteturas de GPU para jogos se alinham com esse roadmap mais amplo que vai até 2027. Ou seja: o gamer pode se sentir ignorado agora, mas muita da pesquisa paga pelo “boom de IA” deve voltar em forma de placas mais eficientes e poderosas no futuro.

Bolha de IA ou nova realidade?

Outra discussão que sempre volta é se tudo isso é uma bolha de IA prestes a estourar. Muita gente que, há um ou dois anos, chamava essa corrida de exagero, hoje está contando FLOPs e comparando consumo de energia de cada novo modelo de GPU. Virou até piada: se a bolha explodir, quem sofre primeiro é o orçamento, não a demanda, e talvez a NVIDIA, que amarrou quase toda sua narrativa ao tema. A AMD, por sua vez, ainda tem uma base diversificada com consoles, PCs, embarcados e CPUs de servidor.

O fato é que você não aposta em cadência anual de aceleradores, não investe em HBM4 e em uma nova geração de interconexões se acha que o mercado vai sumir do dia para a noite. O cenário mais provável é de desaceleração gradual e clientes exigindo menos dependência de um único fornecedor com poder quase monopolista de precificação. É exatamente esse espaço que o combo MI400 + MI500 tenta ocupar.

Resumo: slides hoje, concorrência de verdade amanhã

Neste momento, MI400 e MI500 ainda vivem principalmente como slides de apresentação, metas de desempenho e gráficos comparativos. A prova de fogo virá quando os primeiros protótipos chegarem aos laboratórios de nuvem e supercomputação, e tiverem de enfrentar a maturidade do ecossistema NVIDIA – das bibliotecas ao gerenciamento de cluster. A AMD precisa mostrar que Instinct não é só número bonito em FP4/FP8, mas base estável para clusters grandes, com boa disponibilidade e um stack de software em que desenvolvedores queiram de fato trabalhar.

Se a empresa acertar esses pontos, o ganho potencial é enorme – e não apenas para a própria AMD. A entrada forte de Instinct MI455X e MI430X, seguida pela família MI500, pode mudar contratos, preços e até a velocidade de inovação em IA. No fim, a questão deixa de ser “quem tem o GPU mais rápido” e passa a ser “vamos viver em um mundo de fornecedor único ou em um mercado realmente competitivo?”. A AMD finalmente subiu no ringue; os próximos anos dirão se ela está pronta para mais do que só alguns bons golpes.