AMD organiza fila de clientes em “escala OpenAI” – e prepara o terreno para o Instinct MI450

A AMD deixou de mirar um único supercontrato e passou a falar em vários clientes de porte semelhante ao OpenAI. Na última teleconferência de resultados, a CEO Lisa Su descreveu um funil mais largo e menos dependente de um comprador só: ao invés de remessas isoladas de placas, a proposta envolve racks completos, cronogramas plurianuais e coengenharia com cada cliente para alinhar chip, rede, software e operação de data center. Em outras palavras, vendas repetíveis em escala, não projetos artesanais.

Mas o que significa “escala OpenAI” no mundo real? Trata-se de programar capacidade por fases, em múltiplas regiões, com metas de desempenho e eficiência atreladas a marcos claros (treinamento de modelos, expansão de inferência, SLAs de latência). O fornecedor não só entrega aceleradores; ele amarra CPUs, interconexão, resfriamento e gestão em uma solução de prateleira para que o cliente ligue e produza tokens mais rápido.

Roteiro Instinct: MI355 acelerando, MI450 na H2

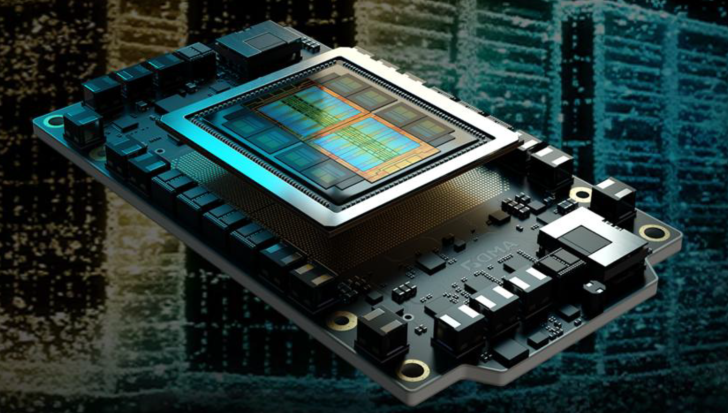

Essa ambição se ancora no roadmap. A família Instinct MI355 já está em rampa de produção, com fôlego previsto até 2026. Em seguida vem a série Instinct MI450, programada para o segundo semestre do próximo ano. A promessa é um salto em performance por watt, largura/ capacidade de memória e densidade por rack – variáveis que derrubam o TCO de treino de fundações e de granjas de inferência de alto throughput. Se o MI450 sustentar mais trabalho no mesmo teto de energia, operadores poderão escalar modelos sem reformar a elétrica do prédio nem reorganizar corredores de resfriamento.

Outro ponto-chave é a entrega de soluções de rack em vez de “kit de peças”. Reduz-se risco de integração, acelera-se o comissionamento e padroniza-se a operação entre regiões. Para quem precisa ativar milhares de GPUs em semanas (não meses), essa padronização vale tanto quanto mais FLOPs.

Gravidade de software: CUDA x ROCm e a portabilidade possível

Hardware sem software é promessa vazia. A NVIDIA desfruta da gravidade de uma década de CUDA, com PyTorch, TensorFlow e bibliotecas profundamente afinados. A aposta da AMD é o ROCm, com esforço pesado em compiladores, kernels e upstream dos frameworks. A conversa com grandes clientes é pragmática: portabilidade assistida por ferramentas, engenharia dedicada e, cada vez mais, histórias de sucesso em produção. Para ambientes que adotam multivendor, essa portabilidade é um seguro contra falta de oferta e contra concentração de poder de preço em um único fornecedor.

Vários megaclientes: menos risco, mais poder de execução

Ter “vários clientes na escala OpenAI” não é só marketing – é gestão de risco. Receita amarrada a um único hiperescalador oscila ao sabor das prioridades do trimestre. Um portfólio distribuído suaviza demanda, aumenta previsibilidade de receita e dá mais voz à AMD na fila de embalagem avançada e de substratos. Com rampas defasadas entre clientes, a empresa pode orquestrar entregas sem “vaporware” e sem choques logísticos.

O que acompanhar daqui para frente

- Throughput medido em produção: tokens/segundo de treino e latência/throughput de inferência em cargas reais.

- Perf/W e densidade: se o MI450 permite crescer capacidade sem novos alimentadores e chillers.

- Maturidade do ROCm: aterrissagem suave de workflows PyTorch/TF e bibliotecas de terceiros.

- Cadência de entregas: cronogramas cumpridos para múltiplos clientes em paralelo, não só “lançamentos de papel”.

Em síntese: a AMD está dobrando a aposta em IA de ponta a ponta – arquitetura, racks, software e base de clientes. Com MI355 ganhando tração e MI450 mirando a H2, o debate muda de “se dá jogo” para “quão rápido dá para integrar mais uma opção de primeira linha nos parques”. Se as promessas de eficiência e de software se confirmarem, “escala OpenAI” deixa de ser slogan e vira a métrica operacional de como o Instinct entra no coração da infraestrutura de IA.

1 comentário

Cheiro de bolha? Talvez. Mas se vier entrega séria e menos fila, vale o hype